La latence réseau ne dépend plus uniquement de la distance entre l’utilisateur et le centre de données. Certaines applications traitent les données là où elles sont générées, bouleversant les modèles traditionnels de gestion informatique. Cette approche redistribue les cartes en matière de rapidité et de sécurité.

Des secteurs entiers révisent leur architecture pour répondre à de nouvelles exigences en matière de traitement en temps réel. Cette dynamique impose de repenser le rapport entre centralisation, coûts et performance.

Edge computing : un concept clé pour comprendre l’évolution de l’informatique

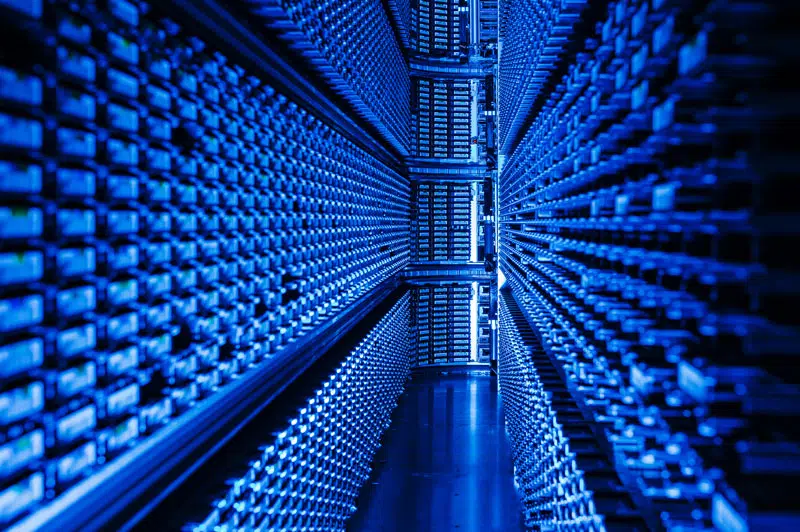

Le edge computing ne se contente pas de faire parler de lui : il transforme en profondeur le traitement des données et rebat les cartes de l’informatique de pointe. Pendant longtemps, la quasi-totalité des flux numériques convergeait vers d’imposants data centers centralisés, véritables remparts numériques. Aujourd’hui, le paradigme change : la puissance de calcul migre vers la périphérie du réseau, au plus près des lieux où naissent les données. Il suffit de penser aux voitures connectées, aux usines automatisées ou aux capteurs agricoles pour saisir l’étendue de ce basculement.

Ce fonctionnement distribué touche directement à l’IoT (internet des objets) et à l’explosion du nombre d’appareils à la périphérie, capables de générer des quantités impressionnantes de données. La latence devient alors un enjeu majeur : dans l’industrie ou la mobilité automatisée, perdre quelques millisecondes peut avoir des conséquences lourdes. Pour un robot qui assemble ou une voiture autonome qui doit réagir, chaque instant compte.

Il ne s’agit pas d’éclipser les centres de données, mais de redistribuer intelligemment les tâches : d’un côté, le cloud computing continue d’assurer le stockage massif et les analyses complexes ; de l’autre, des relais stratégiques traitent localement les flux urgents ou sensibles. Ce duo permet de répondre à des besoins variés, tout en adaptant la puissance informatique aux enjeux du terrain.

Voici les bénéfices que cette approche apporte :

- Réduction de la congestion sur le réseau

- Optimisation de la bande passante

- Traitement des données en temps quasi réel

La diversité des usages, portée par l’essor de l’IoT et la mutation des secteurs industriels, renforce l’intérêt pour ce modèle hybride. Éditeurs de logiciels, fabricants, opérateurs télécoms : tous s’accordent à reconnaître que l’edge computing constitue désormais un pilier de l’évolution informatique.

Pourquoi l’edge computing change la donne face au cloud traditionnel ?

Le cloud computing s’appuie sur la centralisation, la flexibilité et le partage de ressources. Mais l’essor des objets connectés, déployés massivement sur le terrain, bouscule ce modèle. Avec le edge computing, la logique s’inverse : le traitement des données se rapproche des sources, limitant les allers-retours vers des centres de données souvent éloignés et parfois saturés.

Dans des contextes où la latence ne supporte aucune faiblesse, robotique avancée, téléconsultation médicale, conduite automatisée,, le cloud traditionnel montre vite ses limites. L’edge computing répond à cette exigence en traitant les informations quasiment en temps réel, tout en préservant la bande passante. Cette rapidité et cette proximité transforment radicalement les architectures informatiques.

La sécurité sort elle aussi renforcée. Les données les plus sensibles ne sont plus systématiquement envoyées vers un cloud public ou privé : elles peuvent être traitées localement, sous contrôle, avec un périmètre d’exposition réduit. La gestion de la bande passante s’en trouve améliorée, limitant les risques d’encombrement des réseaux principaux.

Ce sont ces changements qui se traduisent concrètement par :

- Réduction de la latence pour les traitements critiques

- Diminution des coûts liés au transit massif de données

- Meilleur contrôle des données principales et des flux sensibles

Plutôt que de remplacer le cloud, l’edge computing s’y greffe et réorganise les équilibres. Il crée un pont entre les infrastructures centralisées et les périphéries, pour orchestrer une nouvelle gestion du traitement informatique.

Des avantages concrets pour les entreprises et les utilisateurs

Les bénéfices de l’edge computing se jouent sur plusieurs tableaux : vitesse, fiabilité, efficacité. Pour les entreprises qui manipulent d’énormes volumes de données, le gain est palpable. Moins de latence, des décisions opérationnelles prises au plus près de l’action et une réduction du trafic réseau. Les data centers respirent, les coûts d’infrastructure sont optimisés.

Côté utilisateurs, l’expérience grimpe d’un cran. Fini les temps morts pour accéder à des applications connectées ou à des objets intelligents. Prenons la vidéosurveillance ou les dispositifs médicaux connectés : les analyses sont réalisées instantanément, la sécurité renforcée. Les données sensibles, traitées sur place, échappent aux risques liés aux transferts massifs.

Pour les responsables IT, la scalabilité prend un sens concret. Lancer de nouveaux services sur la périphérie réseau devient possible sans bouleverser toute l’architecture. Les solutions restent compatibles avec l’existant, ce qui encourage l’interopérabilité et la résilience des systèmes d’information.

Voici les principaux atouts relevés par les organisations qui ont franchi le pas :

- Optimisation de la bande passante

- Réduction des coûts opérationnels

- Renforcement de la confidentialité

- Capacité d’adaptation face à la croissance des appareils IoT

Zoom sur les principaux cas d’utilisation de l’edge computing aujourd’hui

Le traitement des données à la périphérie du réseau bouleverse les habitudes dans de nombreux domaines. Sur les chaînes de l’industrie manufacturière, les capteurs dialoguent avec des microcontrôleurs capables d’analyser les flux en temps réel. Résultat : diagnostics immédiats, maintenance prédictive, interruptions évitées.

En matière de mobilité urbaine, les véhicules connectés, saturés de capteurs, traitent eux-mêmes les signaux de leur environnement. Décisions instantanées pour la conduite autonome, réaction face aux imprévus, sécurité accrue pour tous ceux qui partagent la route.

Dans le secteur de la santé connectée, l’analyse locale des constantes vitales, via des dispositifs médicaux intelligents, simplifie le suivi patient et permet d’alerter plus vite en cas de problème. Le traitement à la source préserve la confidentialité et désengorge les infrastructures hospitalières.

Parmi les usages marquants de l’edge computing, on retrouve :

- Optimisation des réseaux électriques grâce à l’ajustement immédiat des flux d’énergie

- Surveillance d’infrastructures critiques avec détection instantanée d’anomalies ou de pannes

- Déploiement de l’intelligence artificielle embarquée sur terminaux mobiles, permettant la reconnaissance d’image ou de voix sans passer par le cloud

L’essor de l’Internet des objets (IoT) accélère encore l’adoption de ces architectures. Capteurs environnementaux, caméras de sécurité, machines industrielles : tous tirent parti de la proximité du traitement pour gagner en efficacité. Les frontières entre centre, périphérie et utilisateur s’estompent, ouvrant la voie à une informatique plus agile et maîtrisée.